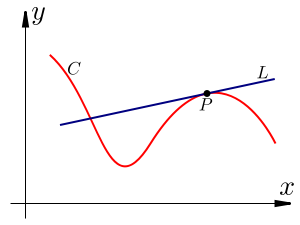

Cominciamo introducendo cos'è la derivata: in termini semplici, la derivata è il coefficiente angolare della retta tangente a una curva (una funzione) che prendiamo in considerazione, in un punto specifico.

L'immagine seguente illustra il concetto graficamente: le immagini, molto spesso, sono più significative delle parole!

La retta L tangente in P alla funzione f ha pendenza data dalla derivata di f in P.

La definizione più precisa richiede l'utilizzo di un altro concetto fondamentale dell'analisi matematica: il limite.

Illustriamo brevemente il concetto di limite (molto semplificato) attraverso un esempio: se noi abbiamo una funzione f(x), per esempio y = (x+5)/x, se volessimo calcolare il limite quando x tende a -1, dovremmo andare a sostituire il -1 all'equazione sopracitata: otterremmo 4/-1 = -4: dunque il limite della funzione considerata è -4.

Pertanto il limite di una funzione, ci indica il valore cui tende la funzione considerata quando x tende a un valore, che può essere un numero reale qualsiasi, oppure infinito.

Prima di concludere la descrizione della definizione di derivata, occorre introdurre un altro concetto: il rapporto incrementale.

Data una funzione y = f(x), consideriamo una sua ascissa x = c e il corrispondente valore della funzione f(c).

Dopodiché prendiamo in considerazione l'ascissa x = c + h, ottenuta incrementando il valore di c di una quantità h, e il corrispondente valore della funzione, ossia f(c+h).

Osserviamo che a un incremento delle ascisse Δx = h corrisponde un incremento delle ordinate Δy = f(c+h) - f(c), che rappresenta l'incremento della funzione quando x passa dal valore c al valore c + h.

Il rapporto incrementale è dunque questo:

Una volta definito il rapporto incrementale, la definizione di derivata è molto semplice: non è altro che il limite del rapporto incrementale, quando l'incremento h tende a 0.

In simboli:

La derivata di una funzione può essere indicata con varie notazioni:

- f'(x)

- y'

- dy/dx: questa è la notazione di Leibniz introdotta nel suo articolo del 1684 dal titolo Nova methodus pro maximis et minimis, itemque tangentibus, qua nec irrationales quantitates moratur.

- Df(x)

Proviamo a calcolare, basandoci sulla definizione, una semplicissima derivata di una funzione: la derivata di y = 3x² - 2x.

Calcoliamo, in primo luogo, il rapporto incrementale: consideriamo la funzione y = 3x² - 2x e la funzione (con l'aggiunta dell'incremento) y = 3(x+h)² - 2(x+h).

Il rapporto incrementale si ottiene così:

Δy/Δx = (3(x+h)² - 2(x+h) - (3x² - 2x))/h.

(3(x² + h² + 2xh) - (2x + h) - 3x² + 2x)/h.

(3x² + 3h² + 6xh - 2x - 2h - 3x² + 2x)/h.

Semplificando: (3h² + 6xh - 2h)/h.

Raccogliendo la h: h(3h + 6x - 2)/h

Si ottiene pertanto: 3h + 6x - 2.

Adesso, calcolando il limite del rapporto incrementale per h che tende a 0: otteniamo 6x - 2: ecco la derivata della funzione!

Questo esercizio poteva essere risolto molto più semplicemente e velocemente facendo ricorso ad alcune regole inerenti il calcolo delle derivate.

In particolare:

Applicando tale regola fondamentale all'esercizio precedente, esso si risolve immediatamente, senza ricorrere a limiti e rapporti incrementali.

Ecco una tabella contenente alcune delle derivate fondamentali:

Andiamo a vedere alcune applicazioni delle derivate in fisica.

La prima che analizziamo riguarda la meccanica classica: consideriamo la legge oraria del moto, ossia la funzione s = s(t) che esprime lo spazio percorso da un corpo al variare del tempo.

Si può definire poi la nota grandezza della velocità media, come Vm = Δs/Δt, cioè spazio percorso diviso tempo impiegato a percorrerlo.

La velocità media assume perciò il ruolo di rapporto incrementale della funzione s = s(t).

Ma sussiste un'altra tipologia ben nota di velocità, la velocità istantanea, ossia quella che un corpo possiede in uno specifico istante.

Essa è il limite della velocità media quando l'intervallo di tempo Δt tende a 0.

Ma la derivata non è il limite del rapporto incrementale quando l'incremento h tende a 0?

Dunque, traslando la definizione di derivata, in questo contesto fisico, possiamo dire che la velocità istantanea non è altro che la derivata dello spazio rispetto al tempo:

v(t) = s'(t)

Proviamo, per esempio, a ricavare da questa formula s(t) = 1/2 at² + V0t + S0, che rappresenta la legge oraria del moto uniformemente accelerato (in cui l'accelerazione a è costante), la velocità istantanea, attraverso il processo di derivazione.

Prima di ciò, specifichiamo che:

-V0 = velocità iniziale;

-S0 = spazio iniziale.

Deriviamo allora tale funzione: otteniamo che 1/2 at² diventa at; V0t diventa V0, mentre S0 scompare.

Alla fine abbiamo che v(t) = V0 + at, che è proprio la formula della velocità istantanea del moto rettilineo uniformemente accelerato. CVD!

Ulteriore notizia: se noi derivassimo per la seconda volta la funzione data, ossia staremmo calcolando la cossidetta derivata seconda, si guardi cosa si ottiene:

Prendiamo v(t) = V0 + at, che è la derivata prima della funzione iniziale; adesso deriviamo ancora, ossia calcoliamo la derivata seconda: il termine V0 scompare, mentre di at rimane solamente a.

Dunque otteniamo la relazione a(t) = a, ossia che l'accelerazione in funzione del tempo è l'accelerazione stessa: cioè a è costante, condizione che avevamo posto inizialmente e che adesso abbiamo verificato.

Inoltre, da questa dimostrazione, si capisce che l'accelerazione istantanea è la derivata prima della velocità istantanea ed è pure la derivata seconda dello spazio rispetto al tempo.

In simboli:

aist = v'(t) = s''(t)

Si percepisce da questi esempi che le derivate ci permettono di ricavare le note formule della fisica che si imparano (spesso) a memoria a scuola: rappresentano, per questo motivo, uno strumento più potente ed efficace per la fisica rispetto agli strumenti dell'algebra classica.

Facciamo un altro esempio di applicazione della derivata in fisica: proviamo a ricavare la nota legge di Hooke sulla forza elastica di una molla.

Prima di tutto è necessario affermare che, quando un corpo si muove lungo una linea retta sotto l'azione di una forza conservativa, l'energia potenziale U è una funzione della sua posizione x e la derivata di tale funzione, cambiata di segno, è uguale alla forza che agisce sul corpo.

Quindi vale tale relazione: F(x) = -U'(x).

Se consideriamo adesso una molla fissata ad una parete, assumiamo come asse x quello della direzione dell'allungamento e consideriamo come origine l'estremo libero della molla nella sua posizione di riposo, si ottiene allora una situazione in cui vale la legge sopracitata.

Siccome l'energia potenziale elastica di una molla deformata con uno spostamento x, è definita in questo modo: U(x) = 1/2 kx², dove k = costante elastica della molla, allora derivando quest'ultima relazione otteniamo:

F(x) = -U'(x) = -kx, che non è altro che la famosa legge di Hooke. CVD!

Abbiamo osservato le proprietà della derivata e la sua importanza in fisica: adesso occupiamoci di un altro importantissimo concetto dell'analisi matematica: l'integrale indefinito.

Bisogna dire che la comprensione di tale strumento, quando si è riusciti a capire cos'è la derivata, viene da sé: infatti derivata e integrale indefinito non sono altro che l'uno l'inverso dell'altro.

Per capire ciò, consideriamo per esempio la funzione y = 2x, che ha derivata y' = 2; adesso consideriamo la funzione y = 2x + 1, che ha derivata y' = 2; consideriamo la funzione y = 2x + 2, che avrà sempre derivata y' = 2.

Notiamo che diverse (anzi infinite) funzioni possiedono sempre la stessa derivata.

Per provarlo nuovamente, basta cambiare la funzione di partenza: y = 3x² ha derivata y' = 6x; y = 3x² + 1 ha derivata sempre y' = 6x e così via.

Le funzioni che danno origini a singole derivate sono dette primitive o antiderivate.

Dettò ciò, l'integrale indefinito è uno strumento che serve, partendo da una funzione derivata qualsiasi, a risalire alle sue infinite primitive.

Prendiamo ad esempio la semplicissima funzione y = x, la cui derivata è y' = 1.

Adesso intraprendiamo il processo inverso: consideriamo y' = 1: come facciamo a risalire alla funzione di partenza (ossia alla famiglia di primitive)?

The answer is: utilizziamo il processo di integrazione!

Possiamo scrivere il tutto in questo modo: ∫(1) dx = x + c.

Altro esempio: data la derivata y' = 2x, l'integrale indefinito è: ∫2x dx = x² + c.

In generale si definisce integrale indefinito di una funzione derivata f(x) l'insieme di tutte e sole le funzioni primitive di f(x).

In simboli:

∫f(x) dx = F(x) + c, dove F'(x) = f(x) con c ∈ R

Quel parametro c che compare non è altro che una costante.

Infatti, se F(x) è una primitiva di f(x), allora anche F(x) + c è una primitiva di f(x) in quanto, come sappiamo, la derivata di una costante è nulla.

Perciò una funzione che ammette una primitiva, ammette infinite primitive e distinte.

Ritornando propriamente all'integrale indefinito, specifichiamo che la scrittura ∫f(x) dx si legge: integrale indefinito di f(x) in dx.

Inoltre, la funzione f(x) che rappresenta una derivata, in questo contesto viene chiamata funzione integranda, mentre la variabile x è detta variabile di integrazione.

Anche per quanto riguarda gli integrali indefiniti ne esistono alcuni fondamentali, riportati qui sotto:

Proviamo giusto a ritrovare l'insieme delle primitive di una semplice funzione: y' = 3sen x:

∫3senx dx = -3cosx + c, in quanto, come riportato sopra, l'integrale indefinito di sen x = - cos x.

Per quanto riguarda le applicazioni alla fisica degli integrali indefiniti, facciamo riferimento alle grandezze fondamentali del moto (spazio, tempo, velocità, accelerazione) e vediamo cosa succede.

Avevamo detto che la velocità istantanea di un corpo è la derivata rispetto al tempo della funzione s(t), che esprime la legge del moto: v(t) = s'(t).

Avevamo anche detto che l'accelerazione istantanea è la derivata della velocità: a(t) = v'(t).

Adesso, conoscendo lo strumento dell'integrale indefinito, possiamo constatare che:

- la legge oraria del moto è una primitiva della velocità, cioè: s(t) = ∫v(t) dt;

- la velocità è una primitiva dell'accelerazione, ossia: v(t) = ∫a(t) dt.

Pertanto, tutte queste leggi riguardanti il moto possono essere espresse in maniera chiara e significativa sfruttando i concetti di derivata e integrale indefinito.

Bene: adesso che abbiamo ultimato questa breve trattazione di alcune proprietà e delle applicazioni fondamentali di tali strumenti matematici in fisica, possiamo introdurre un po' di storia dell'analisi matematica, in cui spicca la celebre disputa tra Newton e Liebniz.

BREVE STORIA DELLE ORIGINI DELL'ANALISI MATEMATICA

Verso la fine del XVII secolo 2 grandissimi scienziati, il tedesco Gottfried Wilhelm Leibniz (1646-1717) e l'inglese Isaac Newton (1642-1727), si contesero il primato di chi avesse dato origine all'analisi infinitesimale.

In realtà, le vere origini di questa importantissima branca della matematica sono molto più antiche: i ragionamenti di Zenone d'Elea (molto celebre per il paradosso di Achille e la tartaruga), le dimostrazioni di Eudosso, i calcoli di Archimede e, successivamente, i lavori di Cavalieri, Galilei, Torricelli, Pascal e Fermat, furono assolutamente determinanti per innestare le condizioni necessarie allo sviluppo di questa nuova disciplina, che inizialmente, prese la denominazione di Calcolo sublime.

Newton aveva introdotto il metodo delle flussioni per risolvere questioni di natura fisica, come il problema della velocità istantanea, mentre Liebniz aveva utilizzato il metodo delle differenze infinitesime per risolvere questioni specificamente matematiche, come il problema della tangente a una curva.

L'inglese aveva scritto (senza però pubblicarli) ben 3 scritti nei quali tentava di giustificare il suo calcolo infinitesimale:

- nel primo (De analysi per aequationes numero terminorum infinitas), del 1669, ammetteva esplicitamente che il suo metodo era "spiegato brevemente piuttosto che dimostrato";

- nel secondo (Methodus fluxionum et serierum infinitarum), risalente al 1671, parlava di grandezze che potevano variare con continuità e assumere valori anche non discreti (usava il termine tecnico "flussione");

- nel terzo (De quadratura curvarum), pubblicato nel 1704, cercava di fornire una spiegazione più precisa e soddisfacente di cosa intendesse per flussione, ma non ci riuscì pienamente.

Infatti, Newton chiarì in maniera migliore la sua concezione di calcolo infinitesimale parlando di fisica nel suo capolavoro Philosophiae naturalis principia mathematica (1687).

Dall'altro lato, Liebniz, aveva pubblicato il suo primo studio sul calcolo infinitesimale negli Acta eruditorum del 1684 e impostato il suo lavoro in maniera completamente originale: parlava di valori che erano "infinitamente piccoli", non pari a 0, ma comunque più piccoli di qualunque numero dato.

Il tedesco prendeva in considerazione 2 punti appartenenti a una curva e affermava che, se essi erano "infinitamente vicini", allora dx era la differenza tra le loro ascisse e dy la differenza fra le loro ordinate.

Liebniz, così come Newton, non riuscì tuttavia a spiegare il suo metodo di calcolo in maniera soddisfacente, tanto che i suoi amici, leggendo il suo primo scritto, commentarono: "Un enigma più che una spiegazione".

Dunque, in questa prima fase, i 2 scienziati si scambiarono lettere e segnali di reciproca stima.

La situazione cambiò profondamente quando, nel 1695, Newton venne a conoscenza che in Europa si attribuiva il merito dell'invenzione del calcolo differenziale a Liebniz: da quel momento in poi i rapporti tra i 2 scienziati si interruppero violentemente.

È necessario specificare che certamente il lavoro di Newton era antecedente a quello di Liebniz, tuttavia l'inglese, come detto in precedenza, non pubblicò nulla.

I risultati di Leibniz, al contrario, non solo furono pubblicati tempestivamente, ma visto che sono stati ottenuti mediante un approccio più geometrico e per molti versi più naturale, fecero rapidamente presa in Europa.

In effetti, ancora oggi, l'approccio alla differenziazione di Leibniz, ossia un approccio geometrico, è quello generalmente adottato nei corsi di calcolo infinitesimale in tutto il mondo e la notazione da egli utilizzata per la derivata è usata spesso anche oggi, mentre la notazione e l'approccio in termini di moto fisico preferiti da Newton, vengono di rado utilizzati al di fuori della fisica.

Si instaurò così una scottante questione, che mutò in aspra polemica: Liebniz era arrivato ad introdurre l'analisi infinitesimale autonomamente, oppure, aveva saputo del nuovo calcolo che Newton stava sviluppando e quindi aveva copiato?

Sussistevano elementi a favore di questa seconda tesi: i 2 scienziati si erano scambiati, nella prima fase, diversi commenti sull'argomento, e ad avvalorare tale ipotesi concorreva il fatto che Liebniz aveva soggiornato a Londra nel 1673, e pertanto era sicuramente entrato in contatto con i lavori di Newton.

Vennero lanciate durissime accuse nei confronti del tedesco.

Su insistenza dello stesso Leibniz, la Royal Society nominò una commissione d'inchiesta per dirimere la questione: l'esito finale (nel 1712) diede ragione a Newton: Liebniz fu accusato di spudorato plagio.

Con ogni probabilità, Newton, in qualità di presidente della Royal Society, non fu estraneo al verdetto della commissione.

Liebniz respinse sempre le aspre accuse imputategli, rivendicando con fermeza l'autonomia delle proprie ricerche, anche se non mise mai in discussione il fatto che Newton avesse inventato per primo l'analisi infinitesimale.

La polemica continuò persino dopo la morte di Leibniz, comportando come conseguenza l'interruzione, per diversi decenni, dello scambio scientifico tra la scuola inglese e quella continentale.

Oggi non ha senso parlare del "vero padre" del calcolo infinitesimale: entrambi diedero contributi fondamentali, che vennero ripresi e implementati dagli analisti successivi.

Inoltre, bisogna osservare che in queste prime formulazioni del calcolo, e in generale per tutto il Settecento, era la derivazione ad esser considerata l'operazione principale, mentre l'integrazione non era vista come un'operazione indipendente, bensì solo come l'inversa della derivazione.

Il posto in secondo piano assunto dall'integrazione durò ben poco, visto che Augustin Louis Cauchy e George Bernard Riemann svilupparono il concetto di integrale definito (indipendente dalla derivazione), importantissimo per calcolare lunghezze, aree e volumi.

Un'ulteriore significativa generalizzazione della teoria dell'integrazione venne da Henry Lebesgue, il quale nel 1902 propose una nuova definizione di integrale, la quale può essere considerata l'estensione della definizione di integrale fornita da Riemann.

Da questo momento, l'integrazione assunse la stessa importanza della derivazione, se non superiore.

P.S.

Dato che siamo in periodo natalizio, pubblico alcuni video inerenti stupende interpretazioni di musiche (anche la musica è matematica!) di Natale:

1) Barbra Streisand in Jingle Bells:

2) Celine Dion in Blue Christmas:

3) Carmen Cavallaro in White Christmas:

4) Renee Olstead in Christmas in Love:

5) Andre Rieu in Silent Night:

6) Kenny G in Have Yourself a Merry Little Christmas:

7) Ryuichi Sakamoto in Merry Christmas Mr. Lawrence:

8) Ella Fiztgerald in Santa Claus is coming to Town:

In più: un video di ripasso delle derivate fondamentali come sorpresa finale!